„Direkt aus der Kamera“, „Out of Cam“, „OoC“, „Ohne Nachbearbeitung“ – das sind Statements, die ich oft bei Bilder lese. Vom Fotografen als eine Art Qualitätsmerkmal gedacht und bei manchen Bild-Konsumenten Ehrfurcht auslösend. Was möchte ein Fotograf damit ausdrücken?

„Das Bild ist ein objektives Abbild der Wirklichkeit“?

„Ich fotografiere so gut, dass das Bild keine Nachbearbeitung braucht“?

Um es vorweg zu nehmen und durchaus provokant zu formulieren:

Out of Cam ist entweder Unfähigkeit oder sogar Faulheit eines Fotografen, Bilder nachzubearbeiten – oder im besten Fall schlicht und einfach Unkenntnis.

Warum gibt es kein unbearbeitetes Bild?

Dazu müssen wir etwas in die Theorie abtauchen. Schauen wir uns dann, was beim Fotografieren passiert:

- Licht fällt durch das Objektiv auf den Sensor der CAM.

- Der Sensor transformiert das Licht in elektrische Spannung.

- Der Grafikprozessor in der Kamera wandelt die elektrischen Größen in digitale Werte um

- Der Grafikprozessor in der Kamera formt aus den einzelnen Werten ein Rohdatenbild (RAW-Bild).

- Der Grafikprozessor in der Kamera speichert das Rohdatenbild ab.

Beine Jade CAM liefert verschiedenen Rohdaten, die in ein bettachtbares Format umgewandelt werden müssen. Dazu gibt es zwei Möglichkeiten:

- Der Grafikprozessor in der Kamera wandelt das RAW-Bild um und speichert ein direkt betrachtbares Bild im z. B. jpg-Format ab.

- Ein RAW-Entwickler auf dem Laptop wie z. B. Capture One oder Lightroom, wandeln das Rohdatenbild in ein direkt betrachtbares Format um.

Im ersten Fall überlassen wir die Interpretation der Rohdaten der Kamera, im 2. Fall haben die volle Kontrolle über die Umwandlung. So weit – so gut. Aber…….

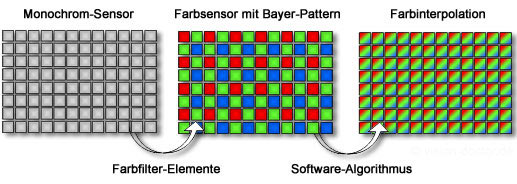

Der Sensor besteht aus vielen kleinen Sensoren, die einen winzig kleinen Teil der Wirklichkeit erfassen. Meist sind es für einen winzig kleinen Teil 4 Sensoren unter Mini Farbfilter: Rot, Blau und 2 x Grün. Moment mal 2 x Grün – warum? Weil das menschliche Auge für den Farbton grün empfindlicher ist, als für blau und rot.

Aufbau Monochrom- und Farbsensor (Bayer-Matrix), Urheber: Lars Fermum https://www.vision-doctor.com

Wenn wir tatsächlich das Bild betrachten würden, das vom Sensor kommt, könnten wir nichts darauf erkennen. In einem allerersten Schritt muss die Kamera die Daten der einzelnen Sensoren zu einem Gesamtbild zusammenrechnen – als RAW-Format. Wenn wir dieses berichten könnten, wäre das ein Bild mit flauen Farben und wenig Kontrasten. „Wenn wir betrachten könnten“ – können wir eigentlich nicht, weil immer, wenn wir ein Raw-Bild öffnen, interpretiert=entwickelt eine Software die Daten so, dass sie ansprechend aussehen. So sieht beispielsweise das gleiche RAW-Bild in Lightroom und Capture One unterschiedlich aus .

So in etwa würde ein unbehandeltes Bild aus der Kamera aussehen.

Erst durch die Entwicklung – egal in der Cam oder in einem externen RAW-Entwickler zeigt sich, was in einem Bild steckt.

Und wenn wir der Kamera sagen , dass sie die Fotos als jpg-Bild abspeichern soll, dann passiert diese Entwicklung=Interpretation bereits in der Kamera. Bei hochwertigen Kameras, können Sie sogar einstellen, ob das jpg mehr Kontraste haben soll oder z. B. etwas mehr Sättigung haben soll. Und die Kamera beschließt selbst oder nach Vorgabe des Fotografen, wie die Farben umgesetzt werden sollen (Weißabgleich). Also greifen Kamera und Fotograf in die Entwicklung massiv ein. D. h. der gleiche Motiv führt in den verschiedensten Kameras zu ganz unterschiedlichen Bildern

Egal, wie sie es anstellen, das Bild wird

– ohne dass Sie das verhindern können –

immer irgendwie entwickelt = bearbeitet.

Die Cam versucht immer so belichten, dass in Summe die Belichtung einem mittleren Wert entspricht. Und das entspricht selten der realen Situation.

Der Raw Entwickler hat zwar die Belichtung angehoben, konnte jedoch mit dem Nachthimmel und den gelblichen Straßenlaternen nicht umgehen.

Genau das hatte ich im Sinn, als ich das Foto geschossen hatte,

Abbild der Wirklichkeit?

Was bedeutet Wirklichkeit – und ich spiele jetzt nicht auf „Matrix“ an. Sondern unsere Wahrnehmung. Wie sehen wir? Vereinfacht nehmen wir nur winzige Details war und reimen uns das Große und ganze nur Zusammen. Wir sehen ein Haus und der Sonne mit offenem Fenster. Was passiert?

Die Wahrnehmung fokussiert sich aufs dunkle Fenster, öffnet die Pupille und stellt den Fokus so ein, dass wir Details im dunklen Raum, erkennen können.

Ein Vogel fliegt im hellen Sonnenschein durchs Bild: Die Wahrnehmung fokussiert sich auf ein Vogeldetail , schließt die Pupille und führt den Fokus der Bewegung des Tieres nach. Die helle Fassade und den Himmel ergänzt unser Gehirn aus der Erfahrung und aus kleinen Details, die die Wahrnehmung zwischendurch einstreut.

Und genau das kann kein Bild leisten. Warum eigentlich nicht?

- Der Dynamikumfang einer Kamera kann das nicht: entweder Details im dunklen Fenster sind erkennbar, dafür ist der Rest komplett überbelichtet, oder der Vogel ist richtig belichtet und das Fenster nur ein schwarzes Rechteck. Das Thema HDR lasse ich jetzt mal außen vor.

- Wir fotografieren selten mit einer Brennweite von 50 mm. 50 mm entspricht weitgehend der Art und Weise, wie wir die Dinge sehen. Das bedeutet, wir verändern den Blickwinkel das Bildes. Der Extremfall wäre ein Ultra Weitwinkel, das Teile stark vergrößert, die nahe an der Kamera sind. Bei z. B. Instagram nutzen viele Smartphones für Selfies. Dazu müssen sie weitwinkelig fotografieren. Und so entstehen Selfies mit großen Augen oder einem großen Schmollmund. Je nachdem, ob der Kopf nach unten oder nach oben geneigt wird. Beim Kopf ohne Neigung wäre übrigens die Nase überproportional vergrößert.

- Nur wenige Bilder sind von vorne bis hinten scharf abgebildet.

- Wir schneiden mit der Kamera nur einen kleinen Teil aus der Wirklichkeit heraus, die Informationen, was rechts und links vom Bild passiert, fehlen.

Z. B. bei einem Vortrag ist oft die erste Reihe fast leer. Ein Foto ,weit vorne fotografiert, kann so einen leeren Saal suggerieren und ein anderes Foto, nur 2 m weiter hinten aufgenommen, ein ausverkauftes Haus. - usw.

Das Hochhaus läuft natürlich nicht nach oben spitz zu. Ich habe nur das Problem der stürzenden Linien hier bewusst ausgenutzt, um ein Gefühl von der Höhe des Gebäudes zu vermitteln.

Ein Foto ist extrem subjektiv – weil wir als „Augentiere“ einem visuellen Abbild blind zu vertrauen.

Ist das schlimm?

Nein gar nicht, ich als Fotograf möchte dem Betrachter eine Situation so zeigen, wie ich die Situation ganz persönlich und subjektiv erlebt habe. Das kann die Kamera nicht, also muss ich nochmal Hand anlegen, um z. B.:

- Die Beleuchtung zu ändern. Wenn ich z. B. im Halbdunkel fotografiere, wird die Kamera immer versuchen das Bild aufzuhellen, also muss ich nachträglich die Belichtung anpassen.

- Die Farben wird die Kamera immer versuchen, einigermaßen realistisch abzubilden. Das geht oft in die Hose. Also muss ich die Farben nachträglich anpassen.

- Übrigens war das genau auch bereits in der analogen Fotografie üblich. Stichworte „abwedeln“ und „nachbelichten“

- Ich kann durch gezielte Nachbearbeitung das Bild nach mehr an mein subjektives Erleben anpassen. Z. B. ich portraitiere einen besonderen Mensch und im Nachhinein stelle ich fest, dass eine Telegrafenleitung im Hintergrund durch den Kopf der Persönlichkeit verläuft. Also Bildretusche marsch – das bin ich als Fotograf schon alleine der Persönlichkeit schuldig.

- Ich habe mal wieder die Kamera nicht ganz gerade gehalten. Es gibt keinen Grund, das in der Nachbearbeitung nicht zu korrigieren.

- Und so weiter und so weiter

Die Digitalfotografie bietet so viele Möglichkeiten darüberhinaus. So fotografiere ich oft einen viel größeren Ausschnitt und lege erst in der Nachbearbeitung fest, was auf dem endgültigen Bild zu sehen sein solll.

Die „Krabbe“ zeigte sich mir erst in der Nachbearbeitung. Eigentlich wollte ich das Bild löschen 😉

„Out of Cam“ ist nicht nur an der Realität vorbei, sondern absoluter Unsinn.

In der klassischen Fotografie musste jedes Bild durch Chemie entwickelt werde. Auch in der Digitalfotografie muss ein Bild entwickelt werden – durch Software. Eine Nachbearbeitung – die Grenzen zum Entwicklen sind fließend – darüber hinaus ist oft sinnvoll. Aber Vorsicht: nicht über das Ziel hinausschießen.

Hinterlasse einen Kommentar